本篇目录:

- 1、程序中的Hive具体是干什么用的呢?

- 2、Hive常用算子实现原理简述--MapReduce版

- 3、impala和hive的区别有什么

- 4、源码级解读如何解决Spark-sql读取hive分区表执行效率低问题

- 5、Hive基础之Hive是什么以及Hive使用场景

- 6、hive数据倾斜及处理

程序中的Hive具体是干什么用的呢?

Hive是一个基于Hadoop的数据仓库工具,用于处理大型分布式数据集,允许用户使用类似于SQL的语言来管理和查询数据。概述 Hive是一个数据仓库工具,可以将数据存储在Hadoop文件系统中,并使用SQL风格的查询语言对这些数据进行操作。

Hive 是一个强大的工具,用于管理和查询大规模数据集,特别适用于数据仓库和数据分析应用。在本技术文件中,我们介绍了 Hive 的核心概念、安装步骤和配置,以及使用 Hive 进行数据操作的基本指南。

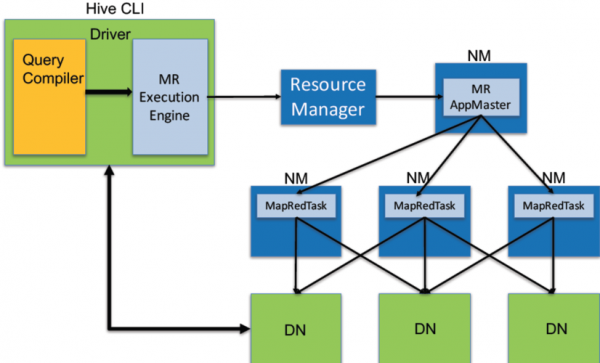

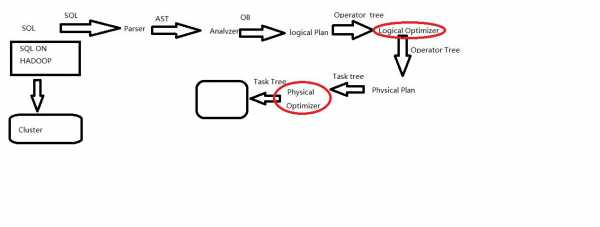

Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射成一张表,并提供类SQL查询功能;其本质是将HQL转化成MapReduce程序。

Hive是一个数据仓库基础工具,它是建立在Hadoop之上的数据仓库,在某种程度上可以把它看做用户编程接口(API),本身也并不存储和处理数据,依赖于HDFS存储数据,依赖MR处理数据。

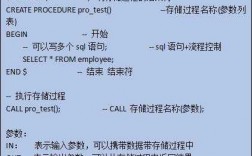

由于编写MapReduce程序繁琐复杂,而sql语言比较简单,程序员就开发出了支持sql的hive。hive的出现方便了程序员和没有计算机背景的数据分析人员。

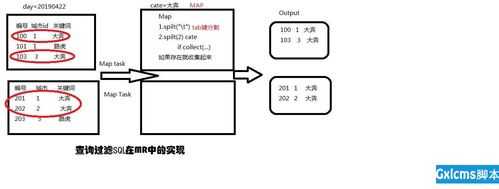

Hive常用算子实现原理简述--MapReduce版

(1)set hive.map.aggr=true,即开启map端的combiner,减少传到reducer的数据量,同时需设置参数hive.groupby.mapaggr.checkinterval 规定在 map 端进行聚合操作的条目数目。

Hadoop处理完全依赖于MapReduce框架,这要求用户了解Java编程的高级样式,以便成功查询数据。Apache Hive背后的动机是简化查询,并将Hadoop非结构化数据开放给公司中更广泛的用户群。Hive有三个主要功能:数据汇总,查询和分析。

大数据,指无法在一定时间范围内用常规软件工具进行捕捉、管理和处理的数据集合,是需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产。想要学习大数据课程推荐选择【达内教育】。

所以,它的map操作很简单,就是按行读文件,然后会根据hive的默认分隔符\001对每行进行切分。切分完成后就会按照你SQL指定的逻辑进行合并,最后再输出成hdfs文件,只不过在hive里面看它是以表的形式展现的。

impala和hive的区别有什么

1、Hive是为方便用户使用Map-Reduce而在外面封装了一层SQL,由于Hive采用了SQL,它的问题域比Map-Reduce更窄,因为很多问题,SQL表达不出来,比如一些数据挖掘算法,推荐算法、图像识别算法等,这些仍只能通过编写Map-Reduce完成。

2、Hive 适合于长时间的批处理查询分析,而Impala适合于实时交互式SQL查询,Impala给数据人员提供了快速实验,验证想法的大数据分析工具,可以先使用Hive进行数据转换处理,之后使用Impala在Hive处理好后的数据集上进行快速的数据分析。

3、Impala自称数据查询效率比Hive快几倍甚至数十倍,它之所以这么快的原因大致有以下几点:真正的MPP查询引擎。使用C++开发而不是Java,降低运行负荷。运行时代码生成(LLVM IR),提高效率。全新的执行引擎(不是Mapreduce)。

4、hive和impala则更偏向于查询分析,impala需要依赖hive的元数据,它们都有自己的查询分析引擎,只是impala是纯查询分析引擎。

5、数据查询分析:Hive的核心工作就是把SQL语句翻译成MR程序,可以将结构化的数据映射为一张数据库表,并提供HQL(HiveSQL)查询功能。Spark启用了内存分布数据集,除了能够提供交互式查询外,它还可以优化迭代工作负载。

6、Pig与HIVE工具类似,都可以用类sql语言对数据进行处理。但是他们应用场景有区别,Pig用于数据仓库数据的ETL,HIVE用于数仓数据分析。

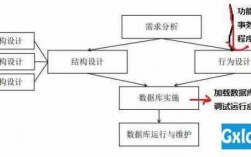

源码级解读如何解决Spark-sql读取hive分区表执行效率低问题

1、对 Hive 的调优既包含对HiveSQL 语句本身的优化,也包含 Hive 配置项和 MR 方面的调整。列裁剪就是在查询时只读取需要的列。

2、都是可以的。所以分区字段过滤大小写敏感问题也应该作为Spark和Hive的一个不兼容点记录下来。另外,社区对这个问题应该有一个issue: https://issues.apache.org/jira/browse/SPARK-19490 也可以根据issue的方式修改源码解决。

3、Hive在极大数据或者数据不平衡等情况下,表现往往一般,因此也出现了presto、spark-sql等替代品。

4、result.rdd.saveAsTextFile(output_tmp_dir)由此可见,对hive的写入操作耗用了大量的时间。对此现象的优化可以是,将文件存为符合hive table文件的格式,然后使用hive load将产生的结果文件直接move到指定目录下。

Hive基础之Hive是什么以及Hive使用场景

1、Hive是一个基于Hadoop的数据仓库工具,用于处理大型分布式数据集,允许用户使用类似于SQL的语言来管理和查询数据。概述 Hive是一个数据仓库工具,可以将数据存储在Hadoop文件系统中,并使用SQL风格的查询语言对这些数据进行操作。

2、Hive 的应用场景涵盖了多个领域,包括但不限于:数据仓库:Hive 可用于构建和维护数据仓库,将各种结构化和半结构化数据集成到一个中心化存储中。

3、hive可以很好的结合thrift和控制分隔符,也支持用户自定义分隔符。hive基于hadoop,hadoop是批处理系统,不能保存低延迟,因此,hive的查询也不能保证低延迟。

4、Hive是建立在 Hadoop 上的数据仓库基础构架。它提供了一系列的工具,可以用来进行数据提取转化加载(ETL),这是一种可以存储、查询和分析存储在 Hadoop 中的大规模数据的机制。

5、集群上,Hadoop 监控作业执行过程,然后返回作业执行结果给用户。Hive 并非为联机事务处理而设计,Hive 并不提供实时的查询和基于行级的数据更新操作。Hive 的最佳使用场合是大数据集的批处理作业,例如,网络日志分析。

hive数据倾斜及处理

1、如果在处理数据时,某个分组聚合的列有较大的倾斜,可以适当调小该值。表关联引发的数据倾斜 解决方案:通常是将倾斜的数据存到分布式缓存中,分发到各个Map任务所在节点。

2、Hive数据倾斜的原因通常包括硬件配置不当、数据倾斜、分区表设计不合理、数据倾斜和分区表设计不合理等。

3、难得周末,整理了一下一周的工作,发现最近被数据倾斜问题折腾的不轻,还是静下心来总结一下,所谓雁过留痕。

4、set hive.map.aggr=true; (默认 : true) 第一个参数表示在 Map 端进行预聚。 因为传到数据量小了,所以效率高了,可以缓解数据倾斜问题。 最主要的参数,其实是 set hive.groupby.skewindata=true; 这个参数有什么作用呢。

到此,以上就是小编对于hive执行sql原理的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏