本篇目录:

数据是怎样处理的

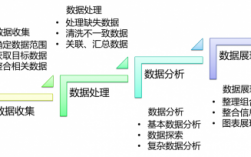

数据处理的三种方法是:数据清洗、数据转换、数据分析。数据清洗 数据清洗是指对原始数据进行筛选、过滤和修正,以使其符合分析的要求。

以下是几种常见的数据处理方法:数据清洗:数据清洗通常是指检查和修复数据集中的错误、缺失值和异常值等问题。这个过程可能涉及到多种技术,如删除不必要的数据、填补缺失值、纠正错误,并排除与实际情况不符的异常值。

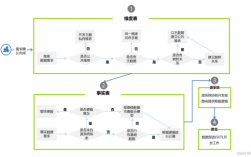

计算机处理数据的流程为:提取阶段:由输入设备把原始数据或信息输入给计算机存储器存起来。解码阶段:根据CPU的指令集架构(ISA)定义将数值解译为指令 执行阶段:再由控制器把需要处理或计算的数据调入运算器。

探索数据在计算机中的处理过程是输入设备--存储设备--控制设备、存储、运算设备--存储设备--输出设备 计算机先要输入数据,然后输入数据要进行存储,然后控制从存储中提取数据进行运算,然后在存储,然后输出。

如何进行大数据分析及处理?

将数据库中的数据经过抽取、清洗、转换将分散、零乱、标准不统一的数据整合到一起,通过在分析数据库中建模数据来提高查询性能。

数据收集:大数据处理的第一步是收集数据。这可以通过各种方式实现,包括从传感器、日志文件、社交媒体、网络流量等来源收集数据。数据预处理:在收集到数据后,需要进行预处理,包括数据清洗、数据转换和数据集成。

大数据处理流程如下:数据采集:收集各种数据来源的数据,包括传感器数据、日志文件、社交媒体数据、交易记录等。数据采集可以通过各种方式进行,如API接口、爬虫、传感器设备等。

数据挖掘算法 可视化是给人看的,数据挖掘就是给机器看的。集群、分割、孤立点分析还有其他的算法让我们深入数据内部,挖掘价值。这些算法不仅要处理大数据的量,也要处理大数据的速度。

大数据的处理 大数据处理之一:采集 大数据的采集是指利用多个数据库来接收发自客户端(Web、App或者传感器形式等)的 数据,并且用户可以通过这些数据库来进行简单的查询和处理工作。

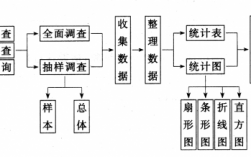

从数据处理的角度,简述数据处理的流程

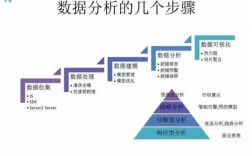

1、大数据处理流程包括:数据采集、数据预处理、数据入库、数据分析、数据展现。

2、数据处理的第一步是收集数据。这可以通过各种方式实现,包括传感器技术、调查问卷、数据库查询等。数据收集需要确保数据的准确性和完整性,以便后续的处理和分析工作能够得到可靠的结果。

3、数据处理的基本流程一般包括以下几个步骤:数据收集:从数据源中获取数据,可能是通过传感器、网络、文件导入等方式。数据清洗:对数据进行初步处理,包括去重、缺失值填充、异常值处理等。

4、大数据处理的六个流程包括数据收集、数据预处理、数据存储、数据处理与分析、数据展示/数据可视化、数据应用。其中数据质量贯穿于整个大数据流程,每一个数据处理环节都会对大数据质量产生影响作用。

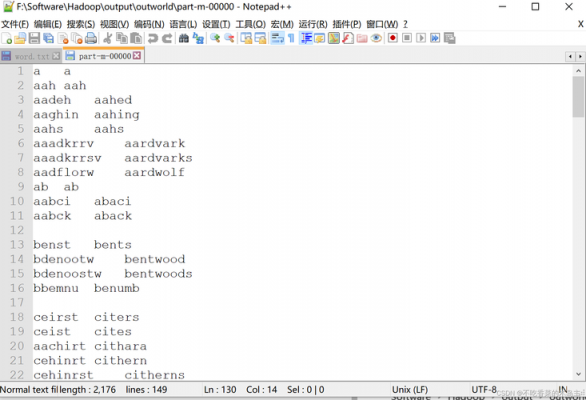

hadoop清理某个分区的数据

hadoop清理某个分区的数据,转载 SQL Server高级进阶之表分区删除 引言 删除分区又称为合并分区,简单地讲就是将多个分区的数据进行合并。

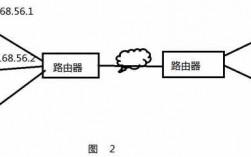

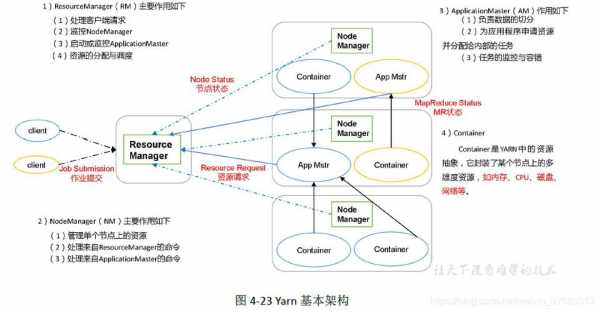

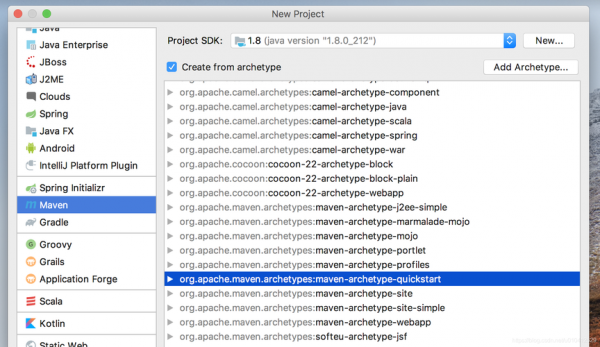

维护文件系统的目录结构,主要就是大量数据的关系以及位置信息等。管理文件系统与block的关系,Hadoop中大量的数据为了方便存储和管理主要是以block块(64M)的形式储存。

一个HDFS集群由一个NameNode、一个主服务器(用于管理系统命名空间和控制客户端文件接口)、大量的DataNode(一般一个节点一个,用于管理该节点数据存储)。HDFS对外暴露了文件系统命名空间并允许在文件中存储用户数据。

方法2:采用hdfs命令进行清空 这个表还剩下一个分区,咱们把这个分区也清空。

通常我们想清除某一分区上的所有数据,一般会在格式化界面选择“快速格式化”,这样就可以快速清除分区里的所有数据。

这些多种多样的数据集操作类型,给上层应用者提供了方便。各个处理节点之间的通信模型不再像Hadoop那样就是唯一的Data Shuffle一种模式。用户可以命名,物化,控制中间结果的分区等。

如何进行大数据处理?

大数据常用的数据处理方式主要有以下几种: 批量处理(Bulk Processing): 批量处理是一种在大量数据上执行某项特定任务的方法。这种方法通常用于分析已经存储在数据库中的历史数据。

数据收集与预处理 数据收集:大数据处理的第一步是收集数据。这可以通过各种方式实现,包括从传感器、日志文件、社交媒体、网络流量等来源收集数据。

将数据库中的数据经过抽取、清洗、转换将分散、零乱、标准不统一的数据整合到一起,通过在分析数据库中建模数据来提高查询性能。

数据收集 数据收集是大数据处理的第一步。这可以通过多种方式进行,如传感器、网页抓取、日志记录等。数据可以来自各种来源,包括传感器、社交媒体、电子邮件、数据库等。

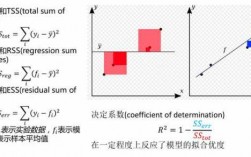

数据处理与分析 这是大数据处理的的核心步骤。在这个步骤中,使用各种数据处理技术和分析方法对数据进行处理和分析。这可能包括数据挖掘、统计分析、机器学习等技术。

到此,以上就是小编对于hadoop误删数据的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏