本篇目录:

怎么优化hadoop任务调度算法

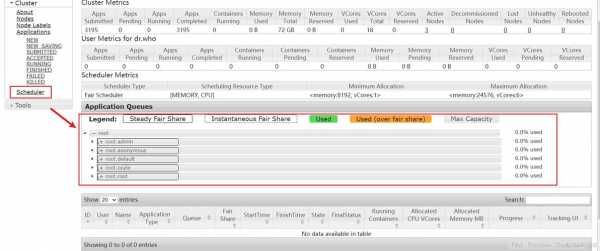

FairScheduler配置方法 在Hadoop配置目录下/usr/local/hadoop/etc/hadoop yarn-site.xml 增加如下信息:新建一个公平调度配置文件fair-scheduler.xml ,信息如下:上述配置以 data_bi 用户名作为公平调度的队列名称。

MapReduce优化方法主要从六个方面考虑: 数据输入、Map阶段、Reduce阶段、IO传输、数据倾斜问题和常用的调优参数。

Hadoop的机架感知Hadoop有一个“机架感知”特性。管理员可以手工定义每个slave数据节点的机架号。为什么要做这么麻烦的事情?有两个原因:防止数据丢失和提高网络性能。为了防止数据丢失,Hadoop会将每个数据块复制到多个机器上。

描述一下hadoop中,有那些地方使用了缓存机制,分别有什么作用

缓存机制就是 DistributedCash ,就是在 job 任务执行前,将需要的文件拷贝到 Task 机器 上进行缓存,提高 mapreduce 的执行效率。

用程序随即生成的,用一个只有map,没有reduce的MapReduce job,在整个集群上先随即生成100亿行数据。然后,在这个基础上,再运行排序的MapReduce job,以测试集群排序性能。

例如,Hadoop 中的 MapReduce 实现中使用了内存缓存机制来减少文件的 I/O 操作次数,加速数据的读写和传输。因此,内存的使用对于MapReduce的性能和效率具有重要的影响。

使用缓存:使用程序直接保存到内存中。或者使用缓存框架: 用一个特定的类型值来保存,以区别空数据和未缓存的两种状态。

维护文件系统的目录结构,主要就是大量数据的关系以及位置信息等。管理文件系统与block的关系,Hadoop中大量的数据为了方便存储和管理主要是以block块(64M)的形式储存。

Avro是新的数据序列化格式与传输工具,将逐步取代Hadoop原有的IPC机制 ApacheAmbari: 是一种基于Web的工具,支持Hadoop集群的供应、管理和监控。

Hadoop:是什么,如何工作,可以用来做什么

1、接收client用户的操作请求,这种用户主要指的是开发工程师的Java代码或者是命令客户端操作。维护文件系统的目录结构,主要就是大量数据的关系以及位置信息等。

2、既可以是Hadoop 集群的一部分,也可以是一个独立的分布式文件系统,是开源免费的大数据处理文件存储系统。

3、快照支持在一个特定时间存储一个数据拷贝,快照可以将失效的集群回滚到之前一个正常的时间点上。HDFS已经支持元数据快照。HDFS的设计是用于支持大文件的。运行在HDFS上的程序也是用于处理大数据集的。

4、Hadoop是用来开发分布式程序的架构,是一个由Apache基金会所开发的分布式系统基础架构。用户可以在不了解分布式底层细节的情况下,开发分布式程序。MapReduce是用来做大规模并行数据处理的数据模型。

5、Hadoop实现了一个分布式文件系统,设计用来部署在低廉的硬件上;而且提供高吞吐量来访问应用程序的数据,适合那些有着超大数据集的应用程序。

6、hadoop是什么意思?Hadoop是具体的开源框架,是工具,用来做海量数据的存储和计算的。

到此,以上就是小编对于hadoop提交任务yarn的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏