本篇目录:

- 1、MapReduce执行过程

- 2、如何用MapReduce程序对采集到的数据进行预处理?

- 3、mapreduce中map是怎么做的?参数又是怎么解析传递给map方法的

- 4、mapreduce的工作流程

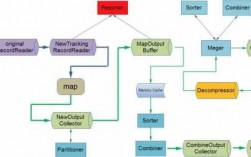

MapReduce执行过程

上面描述的过程是从数据流角度看。而从系统角度看,MapReduce运行用户编写的应用程序过程如下:用户启动MapReduce后,程序会被部署到不同的机器上去。

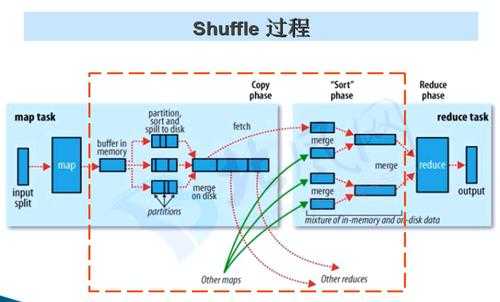

其实不管在map端还是在reduce端,MapReduce都是反复地执行排序,合并操作,现在终于明白了有些人为什么会说:排序是hadoop的灵魂。

图3-3 MapReduce任务执行流程示意图 图3-4 Shuffle过程基本流程图 输入的数据执行map任务后,会先写入到本地缓存中(缓存默认大小是100M),缓存数据达到溢写比(默认是0.8)后,会溢写到本地磁盘中。

分为2个步骤,map和reduce,map专门负责对每个数据独立地同时地打标签,框架会对相同标签的数据分成一组,reduce对分好的那些组数据做累计计算。

总之,在MapReduce的计算模型中,任务分解是实现高性能、高并发处理大数据集的关键环节,需要JobTracker负责分配和协调任务的执行过程。MapReduce简介:MapReduce是一种编程模型,用于大规模数据集的并行运算。

如何用MapReduce程序对采集到的数据进行预处理?

数据预处理通过mapreduce程序对采集到的原始日志数据进行预处理,比如清洗,格式整理,滤除脏数据等,并且梳理成点击流模型数据。数据入库数据入库将预处理之后的数据导入到HIVE仓库中相应的库和表中。

输入分片:在进行Map计算之前,MapReduce会根据输入文件计算输入分片,每个输入分片对应一个Map任务,输入分片存储的并非数据本身。如果输入文件较大,可以进行输入分片调整,例如合并小文件,以优化计算效率。

数据采集和收集:收集各种数据资源,包括数据库、文件、API接口、传感器等。数据清洗:去除不完整、不准确、重复或无关的数据,填补缺失值,处理异常值。

输入:输入数据分为键/值对,由集群中的每个节点处理。映射函数:使用输入数据中的每个键/值对来调用用户定义的映射函数,以生成一组中间键/值对。Shuffle:将中间的键/值对分组,并将其发送到正确的节点。

mapreduce中map是怎么做的?参数又是怎么解析传递给map方法的

1、我们可以看到run()方法首先调用setup()进行初始操作,然后对每个context.nextKeyValue()获取的K-V对,就调用map()函数进行处理,最后调用cleanup()做最后的处理。

2、map中的value是以一行一行的形式从HDFS上指定路径来读取数据的。key就是每行的序号,一般不用管这个key,主要是对Value进行一些处理,然后输出你想要的Key、Value给Reduce做下一步处理。

3、输入分片(input split):在进行map计算之前,mapreduce会根据输入文件计算输入分片(input split),每个输入分片(input split)针对一个map任务,输入分片(input split)存储的并非数据本身。

4、输入分片:在进行Map计算之前,MapReduce会根据输入文件计算输入分片,每个输入分片对应一个Map任务,输入分片存储的并非数据本身。如果输入文件较大,可以进行输入分片调整,例如合并小文件,以优化计算效率。

5、(1) 首先从HDFS中读取数据,并对它做分片操作(split) (2) 每个小分片单独启动一个map任务来处理此分片的数据。

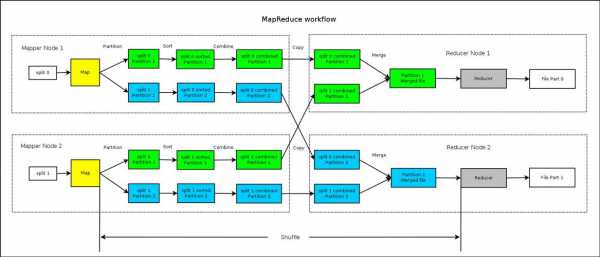

mapreduce的工作流程

mapreduce工作流程如下:输入分片(input split):在进行map计算之前,mapreduce会根据输入文件计算输入分片(input split),每个输入分片(input split)针对一个map任务,输入分片(input split)存储的并非数据本身。

map任务的输入和输出都是key-value (3) 把每个map输出的key-value都进行分区,然后做排序、归并、合并后,分发给所有reduce节点去处理——这个过程称为shuffle。因此map输出的分区数量取决于reduce机器(节点)的数量。

MapReduce存在以下4个独立的实体。 JobClient:运行于client node,负责将MapReduce程序打成Jar包存储到HDFS,并把Jar包的路径提交到Jobtracker,由Jobtracker进行任务的分配和监控。

具体来说,JobTracker负责任务分解的主要流程如下:首先,JobTracker会根据用户指定的Map数量来计算如何将数据集分块。

分为2个步骤,map和reduce,map专门负责对每个数据独立地同时地打标签,框架会对相同标签的数据分成一组,reduce对分好的那些组数据做累计计算。

Hadoop是用来开发分布式程序的架构,是一个由Apache基金会所开发的分布式系统基础架构。用户可以在不了解分布式底层细节的情况下,开发分布式程序。MapReduce是用来做大规模并行数据处理的数据模型。

到此,以上就是小编对于mapreduce过程中描述错误的是的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏