本篇目录:

简述树模型之决策树、随机森林、xgboost

二叉树并不是越深越好,太深会带来overfitting(过拟合)的问题,随机森林构造器的默认参数往往最优。梯度提升决策树。专门处理表格型数据,如pd.DataFrame,基于Boosting。

如下图,假设随机森林中有3棵子决策树,2棵子树的分类结果是A类,1棵子树的分类结果是B类,那么随机森林的分类结果就是A类。

决策树学习通常包括三个步骤:特征选择,决策树的生成和决策树的修剪。而随机森林则是由多个决策树所构成的一种分类器,更准确的说,随机森林是由多个弱分类器组合形成的强分类器。

集成学习通过建立几个模型组合的来解决单一预测问题。它的工作原理是 生成多个分类器/模型 ,各自独立地学习和作出预测。这些预测最后结合成单预测,因此优于任何一个单分类的做出预测。

xgboost通俗理解

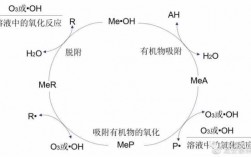

从图中可以看出,xgboost算法中对树的复杂度项增加了一个L2正则化项,针对每个叶结点的得分增加L2平滑,目的也是为了避免过拟合。

Bias-variance tradeoff,Bias可以理解为假设我们有无限多数据的时候,可以训练出最好的模型所拿到的误差。而Variance是因为我们只有有限数据,其中随机性带来的误差。 误差函数尽量去拟合训练数据,正则化项则鼓励更加简单的模型。

决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。数据挖掘中决策树是一种经常要用到的技术,可以用于分析数据,同样也可以用来作预测。

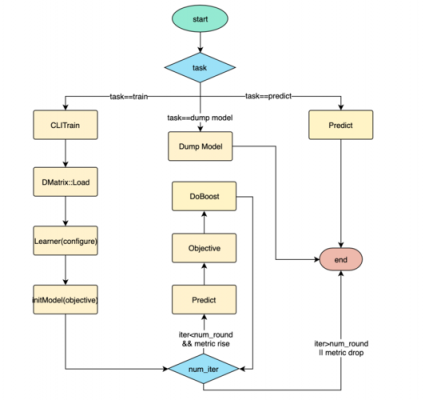

xgboost算法的步骤和GB基本相同,都是首先初始化为一个常数,gb是根据一阶导数ri,xgboost是根据一阶导数gi和二阶导数hi,迭代生成基学习器,相加更新学习器。

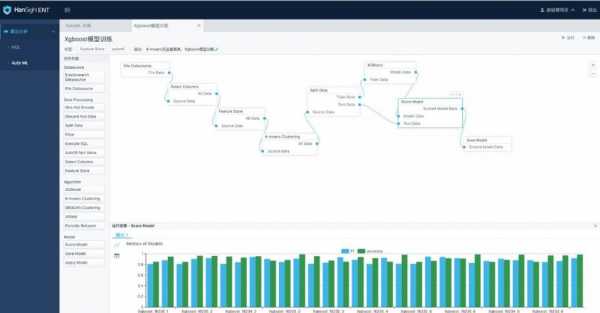

xgboost参数调优

调整参数(含示例)XGBoost的优势XGBoost算法可以给预测模型带来能力的提升。

XGBoost是一种基于树的模型,其中包含许多决策树。在进行训练时,max_depth参数表示树的最大深度。当max_depth值较高时,树的深度更深,这意味着树能够更好地捕捉到数据集中的细微差异,因此可以更好地预测。

—可以通过booster [default=gbtree]设置参数:gbtree: tree-based models/gblinear: linear models 传统GBDT在优化时只用到一阶导数信息,xgboost则对代价函数进行了二阶泰勒展开,同时用到了一阶和二阶导数。

主要区别在于:优化目标不同:GBDT每次迭代优化的目标是损失函数的梯度,而Xgboost优化的是目标函数的目标值。学习率不同:GBDT没有学习率这个参数,而Xgboost有。

而在XGBoost中的Step参数表示梯度下降的步长,通常情况下越小模型收敛的时间更长,越大在训练过程中容易出现振荡,在使用过程中需要多次尝试不同的步长,并进行交叉验证来确定一个最优的超参数。

因此,模型是以相加的方式训练(前向分步算法)的。认为y _i(t)是第i个实例在第t次迭代时的预测,加入一个新的ft来最小化以下目标。

xgboost导读及论文理解

XGBoost 的方法源自于Friedman的二阶方法,XGBoost在正则化目标函数上做了小改进。XGBoost是陈天奇等人开发的一个开源机器学习项目,高效地实现了 GBDT算法 并进行了算法和工程上的许多改进。

答主是wepon大神,根据他的总结我自己做了一理解和补充。 传统GBDT以CART作为基分类器,xgboost还支持线性分类器,这个时候xgboost相当于带L1和L2正则化项的逻辑斯蒂回归(分类问题)或者线性回归(回归问题)。

工程师境地也是很难的一种境地,需求用很强的理论背景和工程完成才能,能独立复现最新的论文,深刻理解论文的完成原理,并能在上面做一些小创新。

XGBoost的缺点及LightGBM的优化 (1)XGBoost的缺点 在LightGBM提出之前,最有名的GBDT工具就是XGBoost了,它是基于预排序方法的决策树算法。这种构建决策树的算法基本思想是: 这样的预排序算法的优点是能精确地找到分割点。

, 基于理解的分词方法:基于理解的分词方法是通过让计算机模拟人对句子的理解 ,达到识别词的效果。其基本思想就是在分词的同时进行句法、语义分析,利用句法信息和语义信息来处理歧义现象。

2019-03-02

1、-03-02期。白鹿,1994年9月23日出生于江苏省常州市,中国内地女演员、模特。2016年7月,白鹿在陆虎单曲《留言》MV里担任女主角,9月,出演个人首部电视剧《朝歌》,从而正式进入演艺圈。

2、《2019年03月02日》【连续第256+1+1+2+3+1+112天总结】学完目标细分和自我鼓励的100个办法,终于知道心态不好,与不会目标细分有关。

3、-03-02期、2020-11-21期和2021-07-31期。白鹿共参加过三次《快乐大本营》,第一次是在2019年3月2日的节目中,她和许凯一起宣传《招摇》这部剧。

4、洞察包含四个部分:市场洞察(了解客户的需求、竞争者的动向、技术的发展、和市场的经济状况以找到机遇与风险)、战略目标、创新焦点、业务模式(涉及六个要素:客户选择、价值主张、价值获取、活动范围、持续价值和风险管理)。

到此,以上就是小编对于batch训练的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏